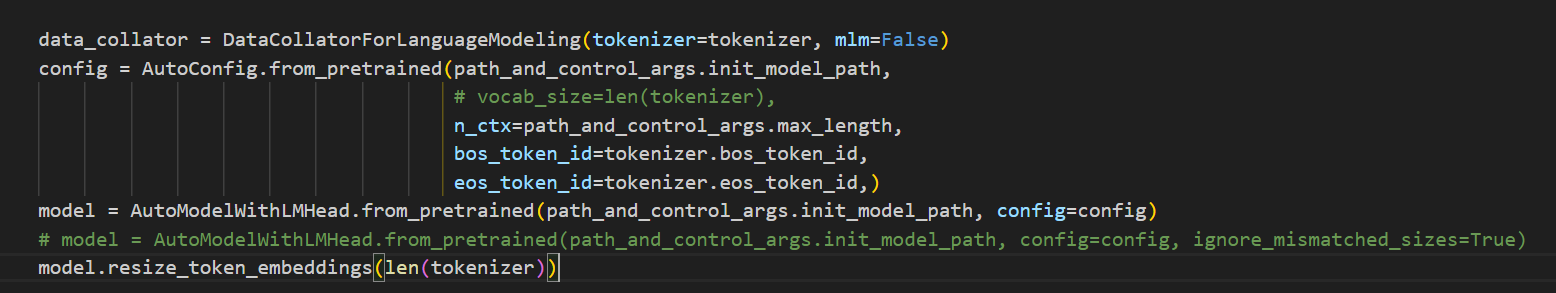

修改模型词嵌入的输入,(vocab_size, embedding_size)m使得模型可以解决多个任务,主要是vocab_size这个

报错解决

1 | RuntimeError: Error(s)in loading state dict for GPT2LMHeadModel:. |

- 原始模型wte层维度为(58257, 768), 而想要其转换为我们所需的(78. 768)

- 初始化模型后直接使用

model.resize_token_embeddings(len(tokenizer))来将wte层的维度设置为tokenizer相同大小